出典:

GT Planet

論文保存サイト、アーカイヴ(arXiv)に投稿された新しい論文では、人間のドライバーに指示を出すのと同じように、視覚的な情報だけを使って、AIに『グランツーリスモ』での走り方を教えられる可能性が示された。

この調査は、ソニーが最近設立したAIのアプリケーションを研究する子会社である「ソニーAI」(Sony AI)が行ったもので、2020年8月に行われた同じような実験と似ているが、いくつかの重要な違いがある、

注釈:2020年8月の実験

前回の研究では、研究者らは

強化学習

の手法を用いて、ゲーム内の環境、物理に基づいて、可能な限り速く走るようにAIを学習させた。

AIは、どのような走りをすれば衝突が起こりラップタイムが遅くなるかを学習し、最終的には「グランツーリスモSPORT」の上位プレイヤーを1周以上周回遅れにする「超人的」な腕前を見せつけた。

今回の方法は、物理的情報に代わりに視覚的な情報を用いたものだ。この論文の主執筆者である今村隆二(Ryuji Imamura)氏は、人間のドライバーが運転の仕方を学ぶ際に使う情報(コースそのもの、HUD、力覚フィードバック)は、AIの学習でも人間と同じように利用できると述べている。

その方法は少し複雑、かつ難解なものである。

AIドライバーを最初の「シード」ラップから数百ラップ(もしくはエポック数(*1))まで走らせ、その間AIドライバーはキャプチャーデバイスやコンソールから提供される速度や加速度といったデータから自分の走りを分析し学習する。そして、そのデータを解析し、次のテストに用の新たな制御出力を生成するというものだ。

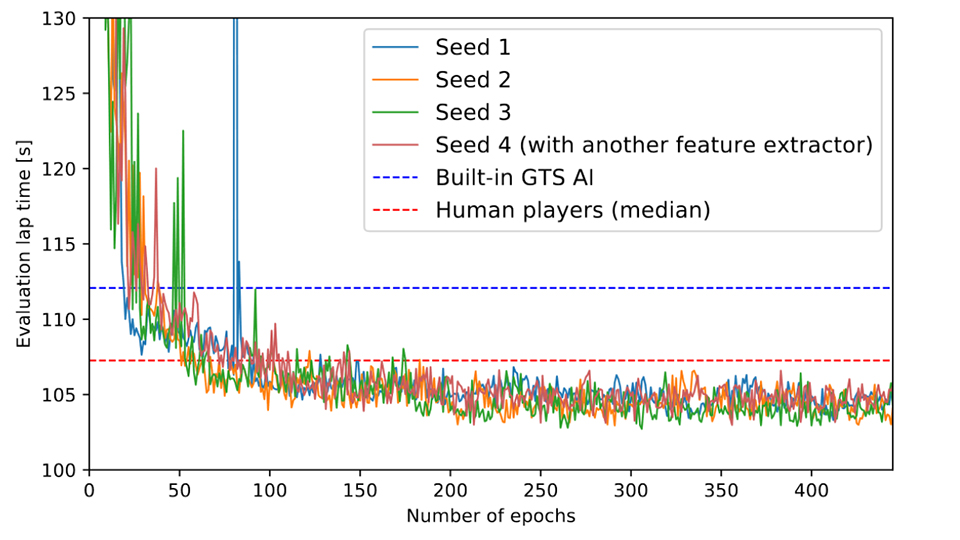

青:シード1 黄:シード2 緑:シード3 赤:シード4 青点線:グランツーリスモSPORTのAI 赤点線:プレイヤーの平均値

各エポック数のラップタイムデータは、先程の「超人」AI研究で使用したデータセットと同じく、ポリフォニー・デジタルが保有する2万8000に及ぶ「マツダ デミオ XD ツーリング '15」の「東京エクスプレスウェイ 中央外回りの」タイムトライアルのラップタイムデータと比較されている。

ご覧の通り、この視覚学習AIはGT SportのAIのラップタイムをすぐに上回っており、およそ20~30エポック数(350~500周に相当)でこのタイムに到達した。

人間のプレイヤーのラップタイムの中央値(下位50%と上位50%を分ける値)を超えるのにもそれほど時間はかからなかったが、200エポック数、つまり約3,500周で改善が停滞したようだ。

最終的に、視覚学習AIは人間のプレーヤーとほぼ同じ情報で学習することで、最速の人間より約3.3秒遅く、中央値の人間より4.5秒速く、GT SportのAIよりなんと9.5秒も速いラップタイムを達成し、上位10%以内のプレーヤーに入ることに成功したのだ。

ポリフォニー・デジタルが、AIドライバーのタイムを向上させるために機械学習を利用する研究に参加するのは、今回で2回目だ。もしかすると、ポリフォニー・デジタルは自分達のAIの限界を自覚して、より良いものにしようと模索しているのではないだろうか?

『グランツーリスモ7』は、AIとのオフラインレースなど、以前のシングルプレイを重視した作りだ。このAI技術が使われれば、より満足度の高いユーザー体験ができるだろう。

翻訳記事一覧へ戻る。